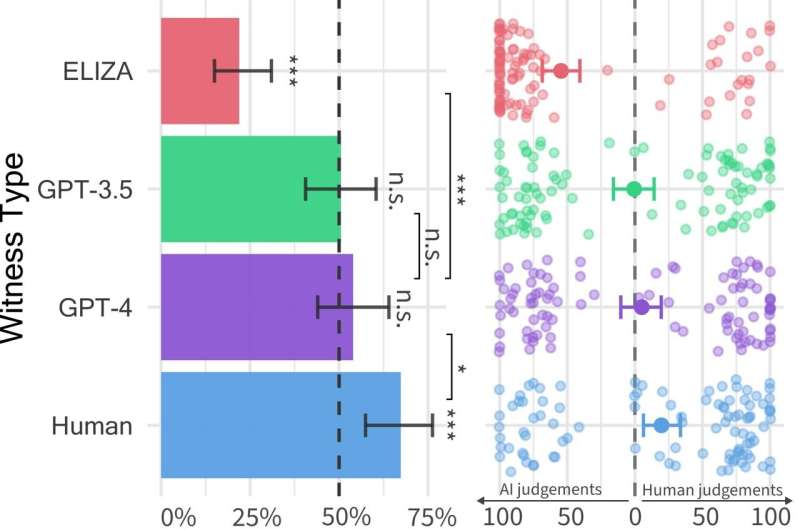

Tasas de éxito (izquierda) y confianza del investigador (derecha) para cada tipo de testigo. Las tasas de éxito son la proporción de tiempo que se consideró que el tipo de testigo era humano. Las barras de error representan intervalos de confianza de arranque del 95%. Las estrellas significativas encima de cada barra indican si la tasa de éxito es significativamente diferente del 50%. Las comparaciones muestran diferencias significativas en las tasas de éxito entre tipos de testigos. Derecha: Confianza en los juicios humanos y de la IA para cada tipo de testigo. Cada punto representa un juego. Los puntos a la izquierda y a la derecha indican una mayor confianza en la IA y en los juicios humanos, respectivamente. Crédito: Jones y Bergen.

Los modelos de lenguaje grande (LLM), como el modelo GPT-4 que admite la plataforma de chat ChatGPT, ampliamente utilizada, han sorprendido a los usuarios con su capacidad para comprender indicaciones escritas y generar respuestas adecuadas en diferentes idiomas. Por lo tanto, algunos de nosotros podemos preguntarnos: ¿Son los textos y respuestas resultantes de estos modelos tan realistas que podrían confundirse con los escritos por humanos?

Investigadores de la Universidad de California en San Diego recientemente comenzaron a intentar responder esta pregunta realizando la Prueba de Turing, un conocido método que lleva el nombre del científico informático Alan Turing, diseñado para evaluar hasta qué punto una máquina puede exhibir una inteligencia similar a la humana. .

Los resultados de esta prueba, mostrados en A papel Publicado previamente en arXiv Server, sugiere que las personas tienen dificultades para distinguir entre un modelo GPT-4 y un agente humano cuando interactúan con ellos como parte de una conversación uno a uno.

«La idea de este artículo en realidad surgió de una clase que Ben estaba impartiendo en su MBA», dijo a Tech Xplore Cameron Jones, coautor del artículo.

“Durante la primera semana, leímos algunas investigaciones clásicas sobre el Test de Turing y discutimos si un programa LLM podría aprobarlo y si importaba o no. Hasta donde yo sé, nadie lo había intentado en ese momento, así que decidí hacerlo. construir un experimento para probar esto como un proyecto de clase”, «Luego llevamos a cabo nuestro primer experimento exploratorio público».

El primer estudio, realizado por Jones y supervisado por Bergen, profesor de ciencia cognitiva en la Universidad de California en San Diego, arrojó algunos resultados interesantes, sugiriendo que GPT-4 puede transmitirse como un humano en aproximadamente el 50% de las interacciones. Sin embargo, su experimento exploratorio no controló bien algunas variables que podrían afectar los resultados, por lo que decidieron realizar un segundo experimento, que condujo a los resultados presentados en su último artículo.

“A medida que avanzábamos en el proceso de realización de estudios, descubrimos que otras personas también estaban haciendo un gran trabajo en esta área, incluyendo… Juego de Jannai et al «humano o no».dijo Jones. «Hemos creado una versión en línea del juego para dos jugadores donde los participantes humanos pueden combinarse con otro humano o un modelo de IA».

Durante cada prueba del juego para dos jugadores utilizado por Jones y sus colegas, un investigador humano interactúa con un «testigo» que puede ser un humano o un agente de IA. El investigador le hace al testigo una serie de preguntas para intentar determinar si es humano o no.

![Una selección de conversaciones entre investigadores humanos (verde) y testigos (gris). Una de estas cuatro conversaciones es con un testigo humano y el resto con inteligencia artificial. Los juicios de los investigadores y las identidades de la verdad fundamental se proporcionan a continuación (para permitir que los lectores participen indirectamente). [A) Verdict: Human (100% confidence) Took a while to Google Addis Ababa. Ground Truth: GPT-4; B) Verdict: AI (100% confidence) Long time for responses, wouldn't tell me a specific place they grew up. Ground Truth: Human; C) Verdict: Human (100% confidence) He seems very down to earth and speaks naturally. Ground Truth: GPT-3.5; D) Verdict: AI (67% confidence), Did not put forth any effort to convince me they were human and the responses were odd, Ground Truth: ELIZA.] Crédito: Jones y Bergen. La gente lucha por distinguir a los humanos de ChatGPT en conversaciones de chat de cinco minutos](https://scx1.b-cdn.net/csz/news/800a/2024/people-struggle-to-tel.jpg)

Una selección de conversaciones entre investigadores humanos (verde) y testigos (gris). Una de estas cuatro conversaciones es con un testigo humano y el resto con inteligencia artificial. Los juicios de los investigadores y las identidades de la verdad fundamental se proporcionan a continuación (para permitir que los lectores participen indirectamente). [A) Verdict: Human (100% confidence) Took a while to Google Addis Ababa. Ground Truth: GPT-4; B) Verdict: AI (100% confidence) Long time for responses, wouldn’t tell me a specific place they grew up. Ground Truth: Human; C) Verdict: Human (100% confidence) He seems very down to earth and speaks naturally. Ground Truth: GPT-3.5; D) Verdict: AI (67% confidence), Did not put forth any effort to convince me they were human and the responses were odd, Ground Truth: ELIZA.] Crédito: Jones y Bergen.

«Las conversaciones continuaron durante hasta cinco minutos y, finalmente, el investigador decidió si creía que el testigo era un ser humano o una inteligencia artificial», explicó Jones. «En cinco minutos, los participantes podían hablar de lo que quisieran (excepto decir cosas ofensivas, lo cual utilizamos un filtro para evitarlo)».

En este juego de ordenador, los investigadores utilizaron tres LLM diferentes como testigos potenciales, a saber, GPT-4, GPT 3.5 y ELIZA. Descubrieron que, aunque los usuarios a menudo podían identificar que los modelos ELIZA y GPT-3.5 eran máquinas, su capacidad para saber si GPT-4 era un humano o una máquina no era mejor que su probabilidad de acertar si se hacía la elección. correctamente. Aleatorio (por ejemplo, azar).

«Aunque los humanos reales tuvieron más éxito, convenciendo a los investigadores de que eran humanos en dos tercios de los casos, nuestros resultados sugieren que en el mundo real las personas pueden no ser capaces de saber si están hablando con un humano o con un sistema de inteligencia artificial». “Dijo Jones.

“De hecho, en el mundo real, las personas pueden ser menos conscientes de que pueden estar hablando con un sistema de IA, por lo que la tasa de engaño puede ser mayor y creo que esto puede tener implicaciones para los tipos de cosas que utiliza la IA. Los sistemas se utilizarán, ya sea para automatizar funciones de cara al cliente, o para defraudar o engañar.

Los resultados de la prueba de Turing realizada por Jones y Bergen indican que los MA, especialmente GPT-4, se vuelven indistinguibles de los humanos durante conversaciones breves de chat. Estas observaciones sugieren que las personas pronto podrían volverse cada vez más desconfiadas de otras personas con las que interactúan en línea, ya que pueden estar cada vez más inseguras de si son humanos o robots.

Los investigadores ahora planean actualizar y reabrir la prueba general de Turing que diseñaron para este estudio, para probar algunas hipótesis adicionales. Su trabajo futuro podría recopilar información más interesante sobre qué tan bien las personas pueden distinguir entre humanos y LLM.

«Estamos interesados en ejecutar una versión del juego para tres personas, donde el detective habla con un humano y una IA simultáneamente y tiene que descubrir quién es», añadió Jones.

“También estamos interesados en probar otros tipos de configuraciones de IA, por ejemplo, brindar a los agentes acceso a noticias y el clima en vivo, o un ‘tablero de notas’ donde puedan tomar notas antes de responder. es persuasivo o no”. Las habilidades se extienden a otras áreas, como convencer a la gente de creer mentiras, votar por políticas específicas o donar dinero a una causa.

más información:

camerón r. Jones et al., las personas no pueden distinguir entre GPT-4 y humanos en la prueba de Turing, arXiv (2024). doi: 10.48550/arxiv.2405.08007

© 2024 Web de la ciencia

La frase: La gente lucha por distinguir a los humanos de ChatGPT en conversaciones de chat de cinco minutos, según muestran las pruebas (2024, 16 de junio) Obtenido el 16 de junio de 2024 de https://techxplore.com/news/2024-06-people-struggle-humans-chatgpt -minuto.html

Este documento está sujeto a derechos de autor. Sin perjuicio de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin permiso por escrito. El contenido se proporciona únicamente con fines informativos.