Muere la Nvidia H100.

Esta semana, Nvidia publicó un artículo de investigación que describe cómo se puede utilizar la IA generativa en el diseño de semiconductores. El científico jefe de Nvidia, Bill Daly, anunció el nuevo artículo durante su discurso de apertura en la Conferencia Internacional sobre Diseño Asistido por Computadora (icad) se está celebrando ahora en San Francisco.

«Este esfuerzo representa un primer paso importante en la aplicación de los títulos LLM al complejo trabajo del diseño de semiconductores», dijo Daly en el evento en San Francisco. «Muestra cómo incluso campos altamente especializados pueden utilizar sus datos internos para entrenar modelos útiles de IA generativa».

«Creo que con el tiempo los grandes modelos de lenguaje ayudarán en todos los procesos, en todos los dominios», afirmó Mark Renn, director de investigación de Nvidia y autor principal del artículo. Nvidia lanzó un Blog Para trabajar junto con papel (ChipNeMo: MBA adaptado al dominio para el diseño de chips).

Diseñar los chips gigantes actuales, como la GPU H100 de Nvidia, normalmente requiere dos años de esfuerzo que involucran a múltiples equipos de ingeniería. La repentina aparición de los campos de LLM y la inteligencia artificial generativa ha provocado una ola de esfuerzos para desarrollar cursos de LLM personalizados y de dominios específicos. LLM en Finanzas de Bloomberg (BloombergGPT) es un buen ejemplo.

Se espera que los LLMS de dominio específico se unan al mundo de las herramientas EDA y aceleren y mejoren significativamente el diseño de chips complejos. En este punto, ChipNeMo es un proyecto interno para uso interno únicamente. El resumen del artículo resume bien el trabajo:

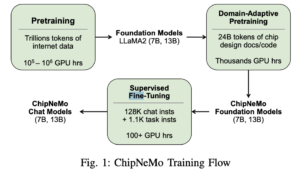

Resumen: «ChipNeMo tiene como objetivo explorar aplicaciones de modelos de lenguaje grandes (LLM) para el diseño de chips industriales. En lugar de implementar directamente LLM comerciales o de código abierto, adoptamos las siguientes técnicas de adaptación de dominio: tokenización personalizada, dominio continuo Ajuste fino supervisado y adaptativo (SFT) previo al entrenamiento con instrucciones específicas de dominio y modelos de recuperación adaptados al dominio.

«Evaluamos estos métodos en tres aplicaciones LLM seleccionadas para el diseño de chips: un asistente de ingeniería, generación de scripts EDA y resumen y análisis de fallas. Nuestros resultados muestran que estas técnicas de adaptación de dominio permiten mejoras significativas en el rendimiento de LLM con respecto a los modelos básicos de propósito general en tres aplicaciones evaluadas». , lo que permite una reducción de hasta 5 veces en el tamaño del modelo con un rendimiento similar o mejor en una variedad de tareas de diseño. Nuestros hallazgos también indican que todavía hay margen de mejora entre nuestros resultados actuales y los resultados idealizados. Creemos que se realizarán más investigaciones en aplicaciones adaptativas con el campo y los métodos LLM ayudarán a cerrar esta brecha en el futuro «.

Sin duda, Nvidia tiene su propio interés aquí, tanto en fortalecer su posición en la comunidad de desarrolladores/proveedores de LLM como en generar demanda para su amplia gama de productos. ChipNeMo está construido con Nvidia nemo Marco en la nube para el desarrollo y la formación de LLM.

Antes de iniciar el proyecto ChipNeMo, Nvidia realizó una encuesta sobre posibles aplicaciones LLM dentro de sus equipos de diseño. Según el artículo, las respuestas se dividieron aproximadamente en cuatro grupos: generación de código, preguntas y respuestas, análisis e informes, y clasificación.

«La generación de código se refiere al código de diseño que crea el LLM, bancos de pruebas, aserciones, scripts de herramientas internas, etc.; Preguntas y respuestas se refiere al LLM que responde preguntas sobre diseños, herramientas, infraestructuras, etc.; Análisis e informes se refiere al LLM que analiza datos y proporciona informes; Clasificación se refiere a un LLM que ayuda a corregir errores de diseño o problemas de herramientas a la luz de registros e informes. Hemos elegido una aplicación principal de cada categoría para estudiar en este trabajo, excepto la categoría Clasificación que dejar para futuras investigaciones.

El documento analiza la estrategia y los pasos dados en el desarrollo de ChipNeMo, proporcionando un modelo aproximado para otros. Evidentemente hay más tareas que se pueden abordar. El blog de Nvidia informó que tiene otros proyectos para diseñar semiconductores utilizando inteligencia artificial Diseñe circuitos más pequeños y más rápidos Y para Colocación mejorada de bloques grandes..

Nvidia dijo que una lección importante aprendida del proyecto ChipNeMo es que los programas LLM de dominios específicos pueden ser bastante pequeños y ejecutarse de manera efectiva en plataformas informáticas más pequeñas.

Esto viene del pantano: «En tareas de diseño de chips, los modelos ChipNeMo personalizados con al menos 13 mil millones de parámetros igualan o superan el rendimiento de ciclos LLM de propósito general mucho más grandes, como LLaMA2 con 70 mil millones de parámetros. En algunos casos de uso, los modelos ChipNeMo fueron mejores En el camino, añadió Ren, los usuarios deben tener cuidado con los datos que recopilan y cómo los limpian para usarlos en la capacitación.

enlace del blog, https://blogs.nvidia.com/blog/2023/10/30/llm-semiconductors-chip-nemo/

enlace en papel, https://d1qx31qr3h6wln.cloudfront.net/publications/ChipNeMo%20%2824%29.pdf

Relacionado

«Fanático del café. Amable aficionado a los zombis. Devoto practicante de la cultura pop. Malvado defensor de los viajes. Organizador típico».